9.3节分布式计算,在三个服务器上同时启动,为什么会一直等待CreateSession still waiting for response from worker: /job:ps/replica:0/task:0,希望高手解答下?

162页中使用的数据集原网站上没有

原书第65页中间“注意这里使用的是不放回抽样,所以并不能保证每个样本被抽到并参与训练。”,应该是有放回抽样吧?事实上在第64页定义的函数 get_random_block_block_from_data(data,batch_size) 就是有放回抽样函数,之后在65页的training_epochs中调用时,也没有把之前训练时选到的data剔除掉,所以我认为应该是有放回抽样,但是这样又会与第64页函数 get_random_block_block_from_data(data,batch_size) 前面的说明文字“这属于不放回抽样,可以提高数据的利用效率”矛盾。

您好,请问:在127页的inception_v3_base函数里,第一个定义的net,运行会报错。报错信息:the ‘kernel_size’ argument must be a tuple of 1 intergers. Received: [3,3]。 我的Tf版本1.0.0-rc0,python版本3.5.2。 期待您的回复

对了,系统是ubuntu 16.04 LTS

发现bug了,原来是生成inputs的那个3写错了位置

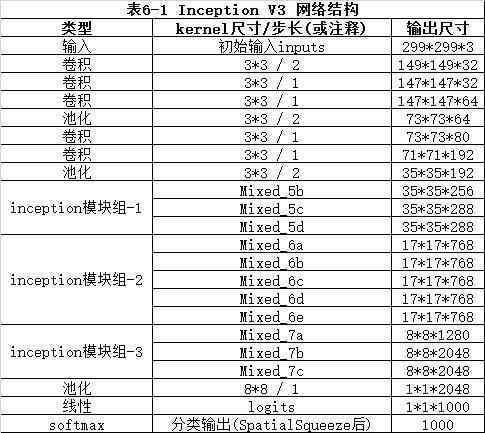

原书里面124-125页表6-1 Inception-v3网络结构如果对照后面提供的源代码看的话,貌似有些错误:卷积池化有的顺序不对。输入尺寸也有地方不符合,按照书里作者提供的代码,我试着整理了一份。

9.3节分布式计算,在三个服务器上同时启动,为什么会一直等待CreateSession still waiting for response from worker: /job:ps/replica:0/task:0,希望高手解答下?

162页中使用的数据集原网站上没有

原书第65页中间“注意这里使用的是不放回抽样,所以并不能保证每个样本被抽到并参与训练。”,应该是有放回抽样吧?事实上在第64页定义的函数 get_random_block_block_from_data(data,batch_size) 就是有放回抽样函数,之后在65页的training_epochs中调用时,也没有把之前训练时选到的data剔除掉,所以我认为应该是有放回抽样,但是这样又会与第64页函数 get_random_block_block_from_data(data,batch_size) 前面的说明文字“这属于不放回抽样,可以提高数据的利用效率”矛盾。

您好,请问:在127页的inception_v3_base函数里,第一个定义的net,运行会报错。报错信息:the ‘kernel_size’ argument must be a tuple of 1 intergers. Received: [3,3]。 我的Tf版本1.0.0-rc0,python版本3.5.2。 期待您的回复

原书里面124-125页表6-1 Inception-v3网络结构如果对照后面提供的源代码看的话,貌似有些错误:卷积池化有的顺序不对。输入尺寸也有地方不符合,按照书里作者提供的代码,我试着整理了一份。