我通过书上面这个链接https://github.com/SherlockLiao/code-of-learn-deep-learning-withpytorch下载代码,但是这个链接打不开

我也打不开。。。

https://github.com/L1aoXingyu/code-of-learn-deep-learning-with-pytorch

@lalalasoso https://github.com/L1aoXingyu/code-of-learn-deep-learning-with-pytorch

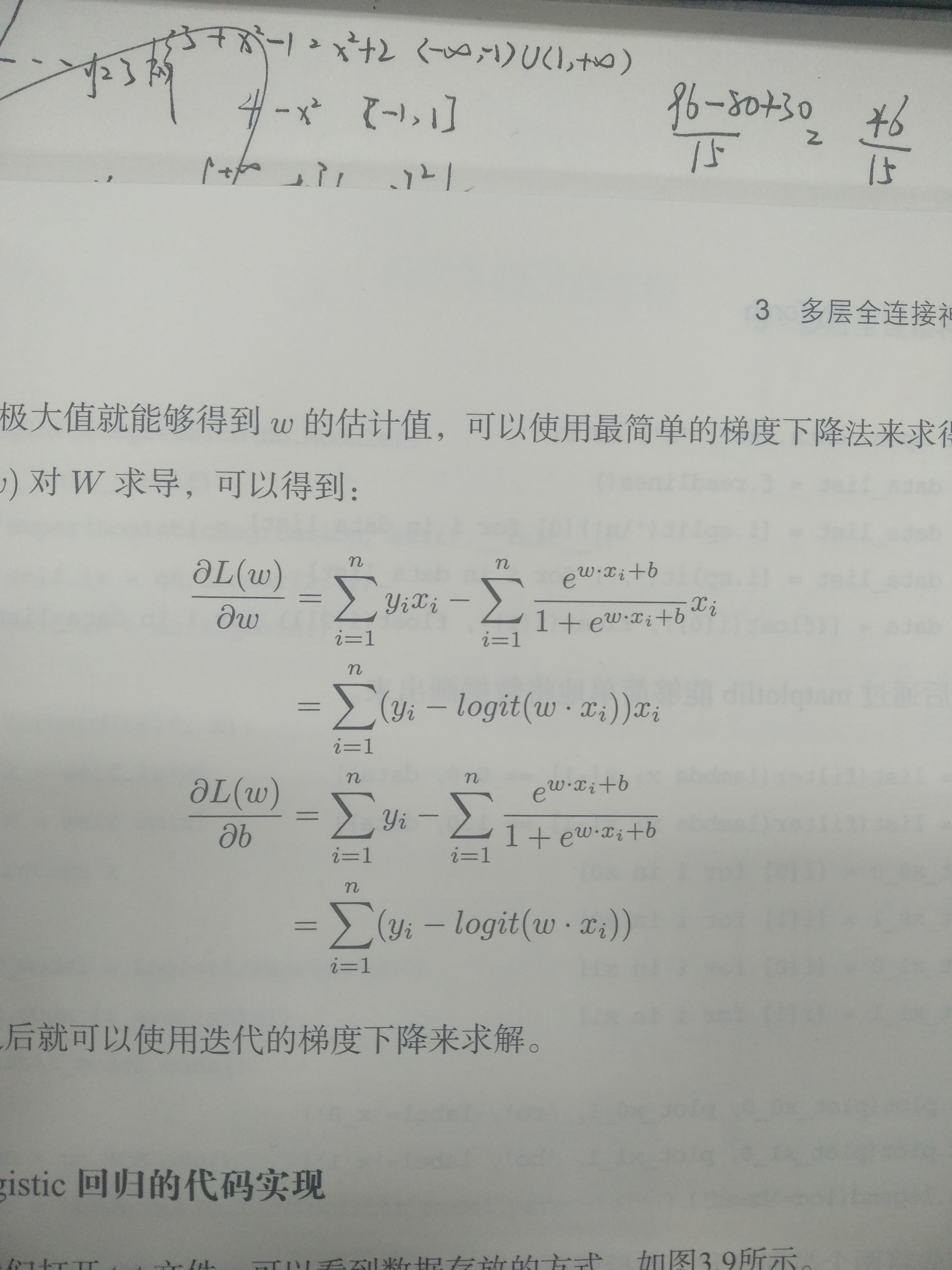

请问这段里的logit(wxi)是怎么转换过来的呢?

本书151页最下方的几行代码:

# loss = 0.5 * sum(1 + log(sigma^2) - mu^2 - sigma^2) KLD_element = mu.pow(2).add_(logvar.exp()).mul_(-1).add_(1).add_(logvar) KLD = torch.sum(KLD_element).mul_(-0.5)

我不太明白为什么KLD里面乘上-0.5呢?上面注释里的loss计算公式里写的明明是乘0.5啊?

还有错别字满天飞

书写的挺垃圾的,还有很多理论知识都是抄别人的,明显的有周志华老师的西瓜书,这些内容还不如不要呢,这些东西增加了字数反正让我觉得没用,内容基本原封不动抄别人的,还有书是真的贵,谨慎入手,后悔了

我通过书上面这个链接https://github.com/SherlockLiao/code-of-learn-deep-learning-withpytorch下载代码,但是这个链接打不开

请问这段里的logit(wxi)是怎么转换过来的呢?

本书151页最下方的几行代码:

我不太明白为什么KLD里面乘上-0.5呢?上面注释里的loss计算公式里写的明明是乘0.5啊?

还有错别字满天飞

书写的挺垃圾的,还有很多理论知识都是抄别人的,明显的有周志华老师的西瓜书,这些内容还不如不要呢,这些东西增加了字数反正让我觉得没用,内容基本原封不动抄别人的,还有书是真的贵,谨慎入手,后悔了